「ChatGPTって一体どんな仕組みで動いているの?」「大規模言語モデル(LLM)って言葉をよく聞くけど、結局何なの?」そんな疑問を言葉の定義から解説します!今や私たちの生活に欠かせなくなった生成AIですが、その裏側で活躍している「大規模言語モデル」について、今日は分かりやすく解説していきます。GPTファミリーの進化からファインチューニング、最新のLoRA技術まで、専門用語を使わずに(できるだけ!)お話しします。

そもそも「モデル」って何?

AIの世界での「モデル」の正体

まるで人間の脳のように、たくさんの情報を覚えて、新しい問題に対して答えを出してくれる仕組みなんですね。

例えば、あなたが写真を見て「これは猫だ」と判断するのと同じように、AIモデルも大量の猫の写真を学習して「この画像は猫である確率が95%」といった予測をしてくれます。つまり、AIモデルはデータから学習したパターンを使って、未知の問題を解決する道具なのです。

なぜ「モデル」と呼ばれるのか

AIが「モデル」と呼ばれるのは、

そもそも「モデル」という言葉は数学や統計学の世界から来ています。

現実の出来事やデータはとても複雑なので、そのままでは扱えません。そこで、重要な特徴だけを取り出して 数式やアルゴリズムで表現した“縮図” を作ります。これを「モデル化」と呼びます。

他にも

人間

人間経済学 → 経済全体を数式で表す「経済モデル」

物理学 → 宇宙の動きを方程式で表す「物理モデル」

統計学 → データから確率分布を当てはめる「統計モデル」

と言われています。AIも同じく、現実のデータを数学的に表す「モデル」を作って使っている、という流れです。

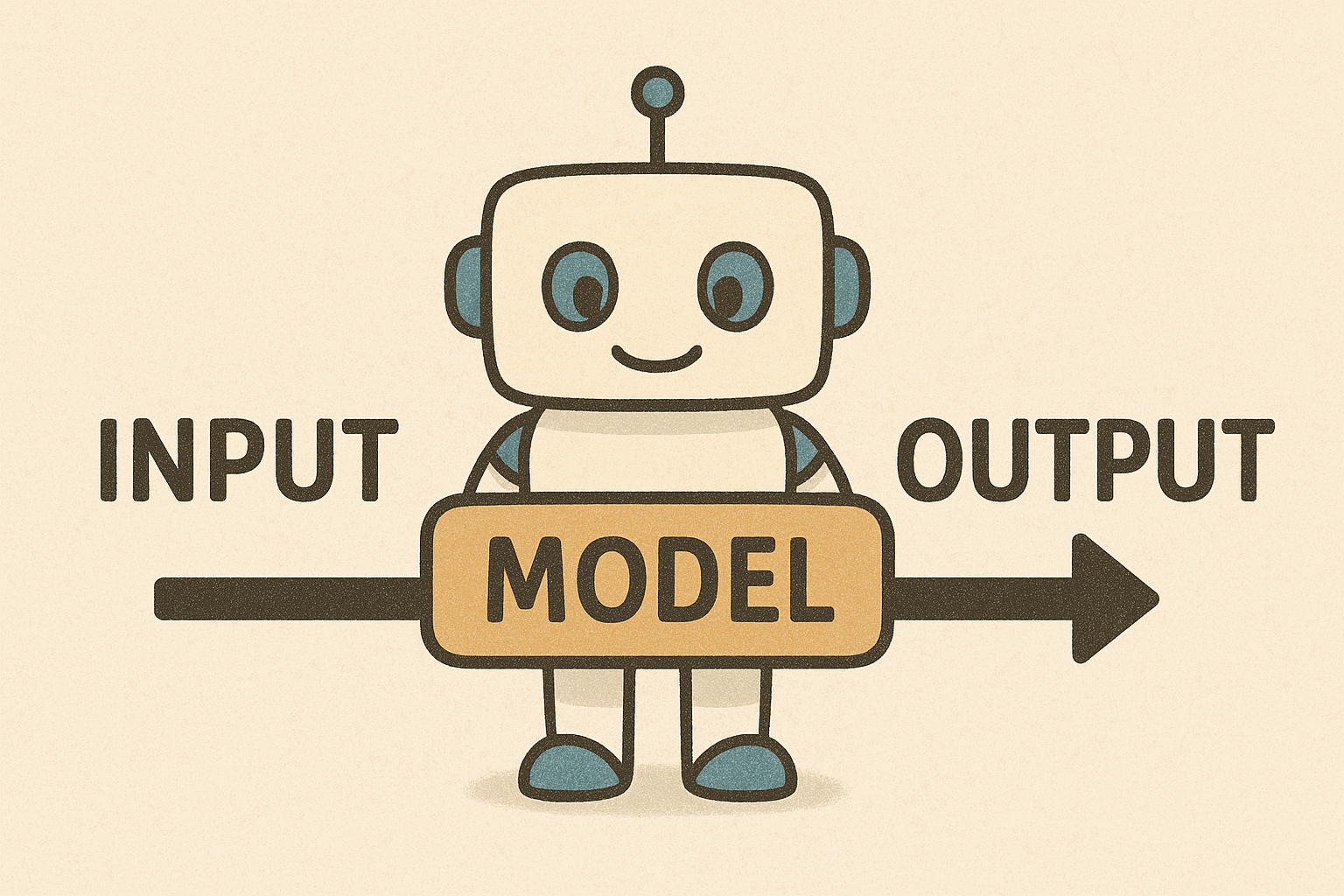

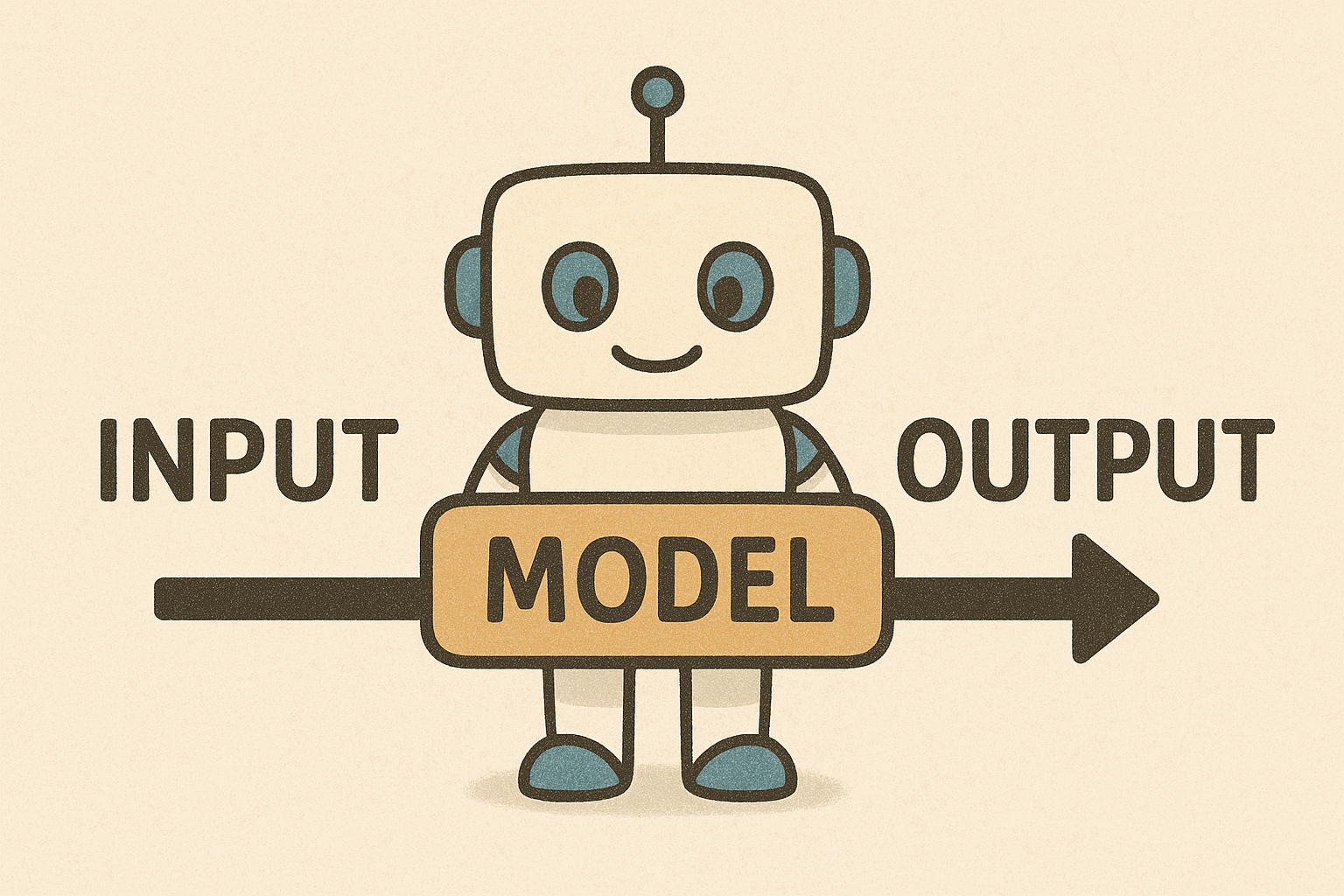

AIでは、大量のデータを学習して、

「入力(質問や画像)」から「出力(答えやラベル)」を導くルールを数学的に近似したものが「モデル」です。

大規模言語モデル(LLM)の正体を暴く!

LLMって結局何者?

さて、いよいよ本題の大規模言語モデル(LLM)の登場です!

大規模言語モデル(LLM)とは、人間が日常的に話したり書いたりする自然言語において、次に出現する単語を予測するためのモデル

『AI活用基本スキル96』著:野村総合研究所、出版社:日経BP 日本経済新聞出版、2025年3月15日

つまり、LLMは「次にどんな言葉が来るか」を予測する超高性能な言葉当てゲームの達人なのです。(「今日の天気は」と入力すれば「晴れです」「雨です」「曇りです」といった適切な続きを予測してくれるわけですね。

「大規模」って具体的にどのくらい?

「大規模」という言葉にビビってしまいそうですが、具体的には以下の3つの要素が「大規模」なんです:

- 計算量:膨大な計算処理が必要

- データ量:インターネット上の文章を大量に学習

- パラメータ数:モデルの「記憶容量」が桁違いに多い

例えば、GPT-3は1750億個のパラメータを持っています。これは人間の脳の神経細胞数(約1000億個)を上回る規模なんですよ!まさに「大規模」という名前にふさわしい、とてつもないサイズなのです。

大規模な分精度かかなり高いモデルっていうことですね

LLMができること・できないこと

LLMの得意分野は本当に幅広くて驚かされます。文章生成、翻訳、要約、質問応答、プログラミング、創作活動など、言語に関することなら何でもこなしてしまいます。

ただし、苦手なこともあります。最新情報は知らない、事実と創作を混同することがある、といった限界もあるんですね。完璧ではないからこそ、人間との協力が大切なのです。

なんでこんな技術が生まれたの?

LLMが生まれた背景には、人間とコンピューターのコミュニケーションをもっと自然にしたいという長年の願いがありました。従来のシステムは決められたコマンドでしか操作できませんでしたが、LLMなら普通の言葉で会話できるようになったのです。LLMの誕生の決定打となったのはトランスフォーマーの登場でした。これにより文脈を理解することができるようになりました。トランスフォーマーについてはこちらの記事でも解説しています!

これにより、プログラミングができない人でも、AIと自然に対話して問題を解決できる時代が到来したというわけですね。まさに技術革新の賜物でしょう!

小規模言語モデル(SLM)という選択肢

LLMの運用コストが高すぎる問題

LLMは確かに素晴らしい技術ですが、実は運用コストがとんでもなく高いという大きな問題があります。GPT-3のような大規模モデルを動かすには、高性能なGPUが何台も必要で、電気代だけでも月に数百万円かかることもあるんです。

これでは個人や中小企業では手が出せませんよね?まるで高級スポーツカーを買ったはいいけど、ガソリン代が高すぎて乗れない状況に似ています。そこで注目されているのが、小規模言語モデル(SLM)なのです。

スマホでもAI!SLMの魅力

小規模言語モデル(SLM)は、パソコンやスマートフォンでも動作する軽量版のLLMです。パラメータ数を数十億個程度に抑えることで、一般的なデバイスでも実行できるようになりました。

SLMの魅力は何といっても手軽さでしょう。インターネット接続が不要で、プライバシーも守られ、しかも無料で使えることが多いんです。性能はLLMに劣りますが、日常的な用途には十分すぎるほどの能力を持っています。

LLMとSLMの使い分け術

では、どう使い分ければいいのでしょうか?複雑で高度な処理が必要な場合はLLM、日常的で軽い処理ならSLMという使い分けが基本です。

例えば、論文の執筆や複雑なプログラミングにはLLMが向いていますが、簡単な質問応答や文章の校正程度ならSLMで十分です。まるで移動手段を選ぶように、目的に応じて適切なモデルを選ぶことが大切なんですね。

スケーリング理論:大きければ大きいほど賢くなる法則

スケーリング理論をざっくり解説

のことです。簡単に言うと「モデルを大きくすればするほど、どんどん賢くなる」という魔法のような現象なんです。

これまでのAI開発では「ちょっと性能を上げるために、ものすごく工夫が必要」という状況でした。しかし、スケーリング理論により「とにかく大きくすれば性能が上がる」という、ある意味単純な解決策が見つかったのです。

なぜ規模が大きいと性能が上がるの?

なぜこんな現象が起こるのでしょうか?その理由はパラメータ数の増加により、より複雑なパターンを学習できるようになるからです。

人間で例えるなら、記憶容量が増えるほどたくさんの知識を覚えられ、より複雑な問題も解けるようになるイメージですね。1000個のパターンしか覚えられない人と、100万個のパターンを覚えられる人では、後者の方が圧倒的に多くの問題を解決できるでしょう。

この理論がAI業界に与えた衝撃

スケーリング理論の発見は、AI業界に「とにかく大きなモデルを作ろう競争」を巻き起こしました。OpenAI、Google、Metaなどの大手企業が、まるで軍拡競争のように巨大なモデルの開発にしのぎを削っているのです。

この理論により、従来の「アルゴリズムの改良」よりも「規模の拡大」に重点が置かれるようになりました。ただし、規模が大きくなるほどコストも膨大になるため、現在は効率化の研究も同時に進んでいるんですよ。

GPTファミリーの進化物語

GPTって何の略?

GPTとは「Generative Pretraining Transformer」の略です。日本語に訳すと「生成的事前学習トランスフォーマー」となりますが、これだけだと何のことやらさっぱりですよね?

簡単に説明すると、「あらかじめ大量の文章で学習しておいた、文章生成が得意なAIモデル」という意味です。「Pretraining(事前学習)」とある通り、最初から学習済みの状態で提供されるのが特徴なんです。

GPT-2からGPT-3への大躍進

GPTファミリーの進化は本当にドラマチックでした。GPT-2(15億パラメータ)からGPT-3(1750億パラメータ)への飛躍は、AI業界を震撼させるほどの衝撃だったのです。

GPT-2の時点でも「こんなに自然な文章を書けるなんて!」と驚かれていたのに、GPT-3は桁違いの性能を見せつけました。まるで子供から大人に一気に成長したような、劇的な変化でしたね。

日本でchatGPTがすごい!って話題になったのはGPT-3の時でしたね

ChatGPTとGPTの関係性

「ChatGPTとGPTって何が違うの?」という疑問をお持ちの方も多いでしょう。

という関係です。

例えるなら、GPTは「優秀だけど少し扱いにくい原石」、ChatGPTは「誰でも使いやすく磨かれた宝石」といったところでしょうか。ChatGPTは人間との対話に特化して、より親しみやすく安全になるよう調整されているのです。

事前学習済みモデルの威力

事前学習済みモデルの最大の魅力は「すぐに使える」ことです。従来のAIは用途ごとに一から学習させる必要がありましたが、GPTなら最初から様々なタスクに対応できる状態で提供されます。

これは料理に例えると、材料から調理する必要がなく、既に美味しく調理された料理がすぐに食べられる状態ということですね。この便利さが、GPTを爆発的に普及させた要因の一つなのです。

ファインチューニング:AIをあなた好みにカスタマイズ

ファインチューニングで何ができる?

のことです。まるでスーツのお直しのように、汎用的なモデルをあなたの用途にぴったり合うようにカスタマイズできるんです。

例えば、医療分野で使いたければ医療文書で追加学習させ、法律分野なら法律文書で学習させることで、その分野に特化した専門家AIを作ることができます。汎用モデルでは難しい、より精密で専門的な回答が可能になるのです。

特定のタスクに特化させる魔法

ファインチューニングの魔法は、少ないデータと計算資源で、大幅な性能向上を実現できることです。ゼロから学習させる場合と比べて、時間もコストも大幅に削減できるんですよ。

これは既に基本的な言語能力を身につけた人が、新しい専門分野を学ぶのと似ています。全くの初心者が医学を学ぶより、既に高等教育を受けた人が医学を学ぶ方が早く習得できるのと同じ原理ですね。だからこそ「魔法」と呼びたくなるほど効率的なのです。

LoRA:ファインチューニングの救世主

ファインチューニングの重すぎる負荷問題

ファインチューニングは素晴らしい技術ですが、実は計算負荷が非常に重いという大きな問題を抱えています。大規模なモデルをファインチューニングしようとすると、膨大なメモリと計算時間が必要になり、個人や小規模な組織では手が出せない状況でした。

まるで巨大な船の方向転換のように、大きなモデルを調整するには莫大なエネルギーが必要だったのです。これでは「ファインチューニングは大企業だけのもの」という状況になってしまいますよね。

LoRAが解決する計算コストの悩み

そこで登場したのがLoRA(Low-Rank Adaptation)という革新的な技術です。LoRAは従来のファインチューニングと比べて、計算コストを大幅に削減しながら、同等の性能向上を実現できる画期的な手法なのです。

具体的には、従来の方法では数千万円かかっていたファインチューニングが、LoRAを使えば数万円程度で実現できるようになりました。これはまさに「民主化」と呼べる変化でしょう。

Low-Rank Adaptationの仕組み

LoRAの仕組みを簡単に説明すると、モデル全体を変更するのではなく、重要な部分だけを効率的に調整する技術です。例えるなら、家全体をリフォームするのではなく、必要な部屋だけを改装するような感じですね。

技術的には「低ランク行列分解」という数学的手法を使っていますが、難しい話は置いておいて、要は「賢い手抜き」で同じ効果を得る方法だと考えてください。この「賢い手抜き」により、個人でも気軽にAIのカスタマイズができる時代が到来したのです。

まとめ:LLMの世界はまだ始まったばかり

この記事では、大規模言語モデル(LLM)の基本から最新技術までを幅広く解説してきました。AIの「モデル」とは何かから始まり、LLMの定義、小規模モデル(SLM)との違い、スケーリング理論、GPTファミリーの進化、そしてファインチューニングとLoRAまで、盛りだくさんの内容でしたね。

特に重要なポイントをおさらいしましょう:

- AIにおけるモデルとは「入力」から「出力」を導くルールを数学的に近似したもの

- LLMは「次の単語を予測する」ことで様々なタスクを実現

- スケーリング理論により「大きくすれば性能が上がる」ことが判明

- SLMにより個人デバイスでもAI活用が可能

- LoRAによりファインチューニングが身近な技術に

LLMの世界は日進月歩で進化しています。今日学んだ知識も、来年には古くなっているかもしれません。でも、基本的な仕組みや考え方を理解していれば、新しい技術が登場しても怖くないはずです!