生成AIの世界には、GANやトランスフォーマー、RAGといった面白い技術がたくさん隠れているんです!今回は、AIが競い合いながら学ぶGANの仕組みから、生成AIの心臓部であるトランスフォーマー、そして最新情報を取り込むRAG技術まで、初心者でもわかりやすく解説します。さらに、なぜAIにGPUが必要なのか、そして未来の人工超知能(ASI)まで、少し応用の内容になっていますが、生成AIの技術を一緒に学んでいきましょう!

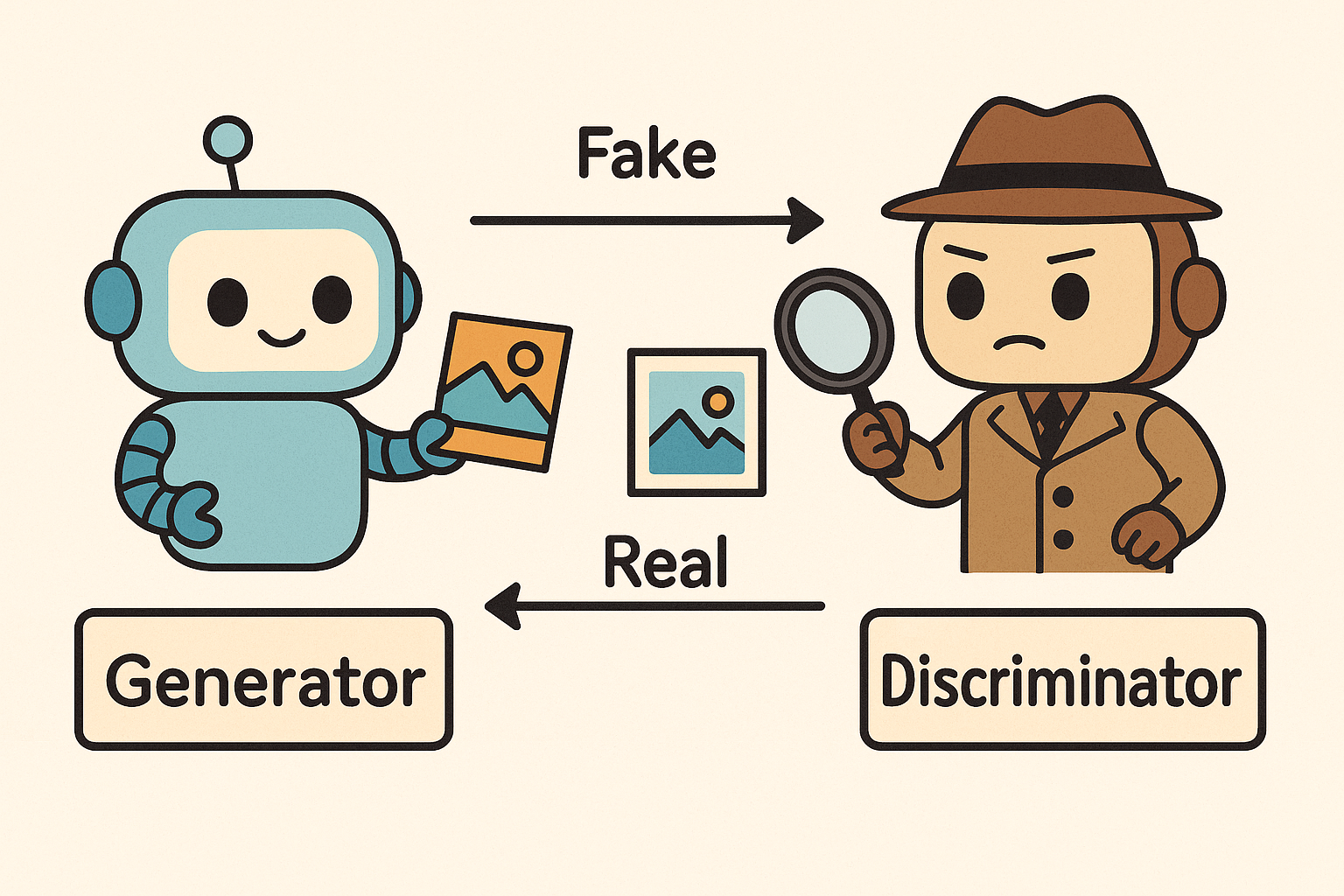

AIがライバルと競い合う?GANの仕組み

GAN(敵対的生成ネットワーク)は、まさにAI界のバトル漫画のような技術です。

2つのニューラルネットワークが競い合いながら、より精度の高い生成モデルを作り上げる仕組み

出典:『AI活用基本スキル96』著:野村総合研究所、出版社:日経BP 日本経済新聞出版、2025年3月15日

この技術の面白いところは、2つのAIが永遠にライバル関係を続けることなんです。一方が「偽物を作る職人」、もう一方が「偽物を見破る探偵」の役割を担っています。この競争によって、どちらもどんどん上達していくという仕組みですね。

生成器と識別器の熱いバトル

生成器(Generator)は、本物そっくりのデータを作り出すクリエイターです。まるで贋作師のように、本物と見分けがつかないほどリアルな画像や音声を生成しようと頑張ります。最初はぼんやりとした画像しか作れませんが、識別器に負けるたびに「次こそは!」と改良を重ねていくんです。

一方、識別器(Discriminator)は、本物と偽物を見分ける鋭い目を持った審査員の役割を果たします。生成器が作った作品を見て「これは偽物だ!」と判定するのが仕事。でも生成器の腕が上がると、識別器も負けじと見分ける能力を向上させていきます。

この永遠の競争こそが、GANの最大の特徴なんですよ。

偽物と本物を見分ける技術

識別器の仕事は、まるで美術品の鑑定士のようなものです。本物の画像データと生成器が作った偽物を見比べて、「これは本物」「これは偽物」と判定していきます。最初は簡単に見分けられるのですが、生成器が上達するにつれて、判定がどんどん難しくなっていくんです。

面白いのは、識別器が「もう見分けられない!」となった時点で、生成器の勝利となること。つまり、本物と区別がつかないほど高品質な偽物を作れるようになったということなんです。

人間

人間この技術は現在、画像生成AIや音声合成、さらには新薬の開発まで幅広く活用されています。

生成AIの心臓部!トランスフォーマーの秘密

トランスフォーマーは、2017年にGoogleが開発した革命的な深層学習モデルです。ChatGPTやGPT-4といった最新の生成AIは、すべてこのトランスフォーマー技術をベースにしているんですよ。まさに現在のAIブームの立役者と言えるでしょう。

この技術が画期的だったのは、従来のAIが苦手だった「文脈を理解する」という能力を大幅に向上させたこと。人間が会話をする時のように、前後の文脈を考慮して適切な応答ができるようになったんです。

トランスフォーマーの最大の特徴は「アテンション機構(注意機構)」という仕組みにあります。これこそが、今回のAI進化において大きな役割を果たした核心技術なんです。

アテンション機構って何?

まるで人間が文章を読む時に、重要な部分に自然と注意を向けるのと同じような仕組みなんですよ。

例えば「太郎は花子にプレゼントをあげた。彼女はとても喜んだ。」という文章があるとします。人間なら「彼女」が「花子」を指すことは当然わかりますよね。でも従来のAIは、この「彼女」が誰を指すのか理解するのが苦手でした。

アテンション機構は、「彼女」という言葉を処理する際に、文章内の「花子」という部分に注意を向けることができます。つまり、文章全体を見渡して、関連性の高い部分を見つけ出す能力を持っているということです。

この技術により、AIは単語一つ一つを独立して処理するのではなく、文章全体の意味を考慮した理解ができるようになりました。

文脈を読むAIの仕組み

従来のAIは、文章を左から右へ順番に処理していくしかありませんでした。まるで一本道を歩くように、一歩ずつ進んでいく感じですね。でもトランスフォーマーは違います。

トランスフォーマーは、文章全体を一度に見渡すことができるんです。

まるで鳥が空から街全体を見下ろすように、文章の全体像を把握してから各部分の関係性を理解していきます。

この「並列処理」の能力により、長い文章でも文脈を保ったまま処理できるようになりました。だからChatGPTは、何回もやり取りを重ねても話の流れを覚えていられるんですね。

さらに、複数の「注意の頭(マルチヘッドアテンション)」を持つことで、同時に複数の観点から文章を分析できます。一つの頭は文法に注目し、別の頭は意味に注目するといった具合に、多角的な理解が可能になったんです。

この革新的な仕組みが、現在私たちが使っている生成AIの高い性能を支えているというわけですね。

AIが最新情報を知る方法:RAG技術

RAG(検索拡張生成:Retrieval-Augmented Generation)は、LLMの大きな弱点を解決する画期的な技術です。ChatGPTなどの大規模言語モデルは確かにすごいのですが、実は大きな問題を抱えているんです。それは「学習データの時点までの情報しか知らない」ということ。

例えば、2023年に学習を終えたAIに「2024年の最新ニュースは?」と聞いても、答えられないんですね。まるでタイムカプセルに入った人が現在の出来事を知らないのと同じような状況です。

RAG技術は、この問題を「外部から情報を取ってくる」という方法で解決します。最近のChatGPTがWeb検索できるようになったのも、まさにこのRAG技術の応用なんですよ。

LLMの弱点を克服する技術

大規模言語モデル(LLM)の最大の弱点は「知識の更新ができない」ことです。一度学習が完了すると、新しい情報を追加するには膨大な時間とコストがかかってしまいます。まるで百科事典のようなもので、新しい版を作るのに何年もかかってしまうんです。

さらに、LLMは時々「知ったかぶり」をしてしまう問題もあります。知らない情報について聞かれても、それらしい答えをでっち上げてしまうことがあるんですね。これを「ハルシネーション(幻覚)」と呼んでいます。

RAG技術は、これらの問題を根本的に解決します。AIが質問を受けた時、まず関連する最新情報を外部のデータベースやWebから検索し、その情報をもとに回答を生成するんです。

具体的な流れはこんな感じです:

- ユーザーが質問する

- AIが関連キーワードで外部情報を検索

- 見つけた情報を参考にして回答を生成

- 情報源も一緒に提示

この仕組みにより、常に最新で正確な情報を提供できるようになりました。

ファインチューニングとの違いとは?

ファインチューニングとRAGは、どちらもAIの能力を向上させる技術ですが、アプローチが全く違います。

ファインチューニングは、既存のAIモデルに新しいデータを追加学習させる方法です。まるで学生が新しい教科書を丸暗記するようなもの。一度覚えれば素早く回答できますが、新しい情報を追加するたびに再学習が必要で、時間とコストがかかります。

一方、RAGは「調べながら答える」方式です。図書館で本を調べながらレポートを書く学生のようなイメージですね。毎回検索する手間はありますが、常に最新の情報にアクセスできるのが大きなメリット。

| 比較項目 | ファインチューニング | RAG |

|---|---|---|

| 更新コスト | 高い(再学習が必要) | 低い(データベース更新のみ) |

| 回答速度 | 速い | やや遅い(検索時間が必要) |

| 情報の新しさ | 学習時点まで | リアルタイム |

| 専門知識 | 深く学習可能 | 幅広くカバー |

現在多くの企業が、この2つの技術を組み合わせて使っています。基本的な知識はファインチューニングで身につけさせ、最新情報や専門的な詳細はRAGで補完するという「いいとこ取り」の戦略ですね。

なぜAIにはGPUが必要なの?

GPU(Graphics Processing Unit)は、もともとゲームの美しいグラフィックを描くために開発されたプロセッサです。でも今では、AIの学習や推論において欠かせない存在になっているんです。なぜゲーム用のチップがAIに必要なのでしょうか?

その答えは「並列処理」にあります。AIの計算は、まさに大量の単純な計算を同時に行う必要があるんです。これは、画面上の何千ものピクセルを同時に処理するゲームグラフィックと非常に似ているんですね。

現在のAIブームは、GPUの性能向上と密接に関係していると言っても過言ではありません。特にNVIDIA社のGPUは、AI業界で圧倒的なシェアを持っており、「AIの心臓部」とも呼ばれています。

CPUとGPUの違い

CPUとGPUの違いを理解するには、料理に例えるとわかりやすいでしょう。

CPU(Central Processing Unit)は、熟練したシェフのような存在です。複雑な料理を一人で丁寧に作ることができますが、同時に作れる料理の数には限界があります。CPUは通常4〜16個程度のコア(作業員)しか持っていないため、複雑な処理は得意ですが、大量の単純作業は苦手なんです。

一方、GPUは大勢のアルバイトスタッフがいるファストフード店のような存在です。一人一人はシンプルな作業しかできませんが、数千人が同時に働くことで、大量の注文を効率よくさばくことができます。GPUは数千個のコアを持っているため、単純な計算を大量に並列処理するのが得意なんです。

AIの学習では、ニューラルネットワークの重みを調整するために、膨大な数の行列計算を行う必要があります。これらの計算は比較的単純ですが、とにかく数が多い。まさにGPUの得意分野というわけですね。

並列処理のパワー

AIの学習において、並列処理がなぜこれほど重要なのでしょうか?

例えば、画像認識AIを学習させる場合を考えてみましょう。AIは何万枚もの画像を見て、「これは猫」「これは犬」といった判別を学習します。この時、各画像のピクセル情報を数値化し、それらを複雑な数式で処理していくんです。

一枚の画像でも、数百万個のピクセル情報を処理する必要があります。これをCPUで順番に処理していたら、何日もかかってしまうでしょう。でもGPUなら、数千個のコアが同時に異なるピクセルを処理できるため、処理時間を大幅に短縮できます。

実際の数字で比較すると驚くほどの差があります:

- CPU: 複雑な計算を高速で処理(シングルスレッド性能重視)

- GPU: 単純な計算を大量に並列処理(マルチスレッド性能重視)

- 処理速度: AIの学習において、GPUはCPUの10〜100倍速い場合も

最近では「GPU不足」が深刻な問題になっているほど、AI開発にGPUは欠かせない存在となっています。ChatGPTのような大規模なAIを学習させるには、数千台のGPUを並列で動かす必要があり、その電気代だけでも数億円かかると言われているんです。

まさに現代のAI革命は、GPUの進化と共に歩んできたと言えるでしょう。

人類を超えるAI:AGIとASIの未来

現在のAIは「特化型AI」と呼ばれ、特定の分野でのみ優秀な能力を発揮します。ChatGPTは文章生成が得意ですが、ロボットを動かすことはできません。画像認識AIは写真の中身を判別できますが、会話はできないんです。

でも将来的には、人間のようにあらゆることができる「汎用人工知能(AGI)」、そしてさらにその先にある「人工超知能(ASI)」の登場が予想されています。これらは一体どのような存在なのでしょうか?

AGIとASIの実現は、人類史上最大の変革をもたらす可能性があります。同時に、慎重な議論と準備が必要な重要なテーマでもあるんです。

汎用人工知能(AGI)とは

汎用人工知能(AGI:Artificial General Intelligence)は、人間と同等の知能を持つAIのことです。現在のAIが「一つのことに特化した専門家」だとすれば、AGIは「何でもできる天才」のような存在と言えるでしょう。

AGIの特徴は以下の通りです:

- 学習能力: 新しいことを人間と同じように学習できる

- 応用力: 学んだ知識を別の分野に応用できる

- 創造性: 新しいアイデアや解決策を生み出せる

- 自己認識: 自分自身について理解している

- 感情理解: 人間の感情を理解し、適切に対応できる

現在のAIとAGIの違いは、「専門医」と「総合診療医」の違いのようなものです。専門医は特定の病気については詳しいですが、AGIは人間の医師のように幅広い知識を持ち、患者の心のケアまでできるイメージですね。

多くの専門家は、AGIの実現時期を2030年代から2050年代と予測しています。ただし、これは技術的な課題だけでなく、倫理的・社会的な問題も含めて慎重に進める必要がある分野なんです。

人工超知能(ASI)の可能性と課題

ASIが実現すると、どのようなことが可能になるでしょうか?

可能性:

- 科学研究の飛躍的進歩: 癌の治療法や気候変動の解決策を短期間で発見

- 技術革新の加速: 現在では想像もつかない新技術の開発

- 社会問題の解決: 貧困、飢餓、戦争などの根本的解決

- 宇宙探査の進展: 人類の宇宙進出を大幅に加速

一方で、重大な課題と懸念も存在します:

- 制御の問題: 人間よりも賢いAIを、人間が制御できるのか?

- 雇用への影響: 多くの仕事がAIに取って代わられる可能性

- 格差の拡大: ASIを持つ者と持たない者の間の格差

- 存在意義の問題: 人間の存在価値や目的は何になるのか?

多くのAI研究者が「ASIの開発には極めて慎重なアプローチが必要」と警鐘を鳴らしています。なぜなら、一度ASIが誕生すると、その後の展開を人間がコントロールできなくなる可能性があるからです。

現在、世界中の研究者や政策立案者が、「AI安全性(AI Safety)」という分野で、安全で有益なAIの開発方法について議論を重ねています。ASIは人類にとって最大の機会であると同時に、最大のリスクでもあるのです。

重要なのは、これらの技術を恐れるのではなく、正しく理解し、適切に準備することなんですね。

まとめ:生成AIの応用技術を理解しよう

今回は、生成AIの応用技術について幅広く学んできました。どの技術も、一見複雑に見えますが、基本的な仕組みを理解すれば決して難しいものではありませんよね。

GAN(敵対的生成ネットワーク)では、2つのAIが競い合いながら成長する面白い仕組みを学びました。まるでライバル同士が切磋琢磨することで、お互いを高め合っているような技術でしたね。

トランスフォーマーは、ChatGPTの心臓部とも言える技術で、アテンション機構によって文脈を理解する能力を身につけました。これが現在のAIブームの基盤となっているんです。

RAG技術は、LLMの弱点を補う画期的な仕組みでした。常に最新の情報にアクセスできるこの技術により、AIはより実用的な存在になっています。

GPUの重要性も理解できました。並列処理の力によって、AIの学習時間を大幅に短縮し、現在のAI革命を支えている縁の下の力持ちでしたね。

そしてAGIとASIという未来のAIについても学びました。大きな可能性と同時に、慎重な議論が必要な重要なテーマであることがわかりました。

これらの技術は、すべて私たちの生活をより豊かにするために開発されています。完璧に理解する必要はありませんが、基本的な仕組みを知っておくことで、AI時代をより楽しく、そして賢く生きていけるはずです!